【StreamSets】 JDBC_502 - Batch size greater than maximal batch size allowed in sdc.properties

【问题描述】

今天在CDH集群中使用StreamSets的时候报了如下的错误:JDBC_502 - Batch size greater than maximal batch size allowed in sdc.properties, maxBatchSize: 1000

【问题原因】

看错误很明显,默认的maxBatchSize:为1000,咱们从数据源中读取的记录数大于1000,于是会报这个错误。

【解决办法】

CDH监控界面找到StreamSets的配置页面,搜索production.maxBatchSize,将默认值调大:

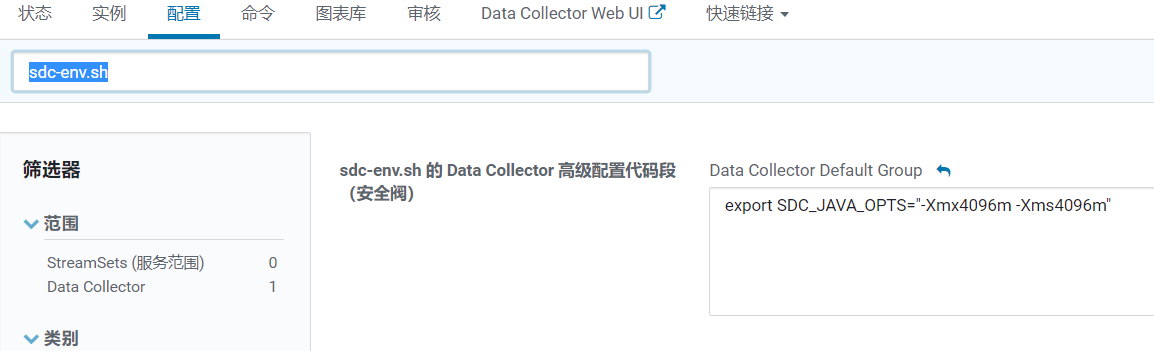

这里需要注意的是,这个阈值调大之后,很可能会报Java内存溢出的情况,这里最好调大一下相关的配置:

默认是1G,这里小编设置为4G。

还没有评论,来说两句吧...