【论文阅读】Low-Resource Knowledge-Grounded Dialogue Generatio

Low-Resource Knowledge-Grounded Dialogue Generatio

论文:https://arxiv.org/abs/2002.10348

任务

以知识为基础的对话,作为反应生成模型的训练数据,很难获得。本文在有限的训练数据下,进行以知识为基础的对话生成。

在这项工作中,专注于以文档为基础的对话生成,但所提出的方法实际上为低资源知识为基础的对话生成提供了一个通用的解决方案,其中的知识可以是结构化的知识库、图像或视频。要做到这一点,只需要修改知识编码器和知识处理器,使其与特定类型的知识兼容,并预先训练知识编码器。

方法(模型)

在低资源环境下,设计了一个分解反应解码器(disentangled response decoder),以便从整个生成模型中分离出依赖于knowledge-grounded的对话的参数。通过这种方式,模型的主要部分可以从大量无基础的对话和非结构化文档中学习,而剩余的小参数则可以用有限的训练实例很好地拟合。

贡献:

- 在低资源环境下探索以知识为基础的对话生成

- 提出了用无基础的对话和文档对以知识为基础的对话生成模型进行预训练的建议

- 在两个基准上对该模型的有效性进行了实证验证

dataset D S D_S DS:

D S = ( U i S , D i S , r i S ) i = 1 n D_S= {(U^S_i, D^S_i, r^S_i)}^n_{i=1} DS=(UiS,DiS,riS)i=1n

D i S D^S_i DiS:文档

U i S U^S_i UiS:上下文

U i S = ( u i , 1 S , . . . u i , n i S ) U^S_i=(u^S_{i,1},…u^S_{i,n_i}) UiS=(ui,1S,…ui,niS)

r i S r^S_i riS:关于 U i S , D i S U^S_i , D^S_i UiS,DiS的response

学习目标:生成式模型 P ( r ∣ U , D ; θ ) P(r|U, D; θ) P(r∣U,D;θ)

给定文档D和与之关联的对话上下文U,通过 P ( r ∣ U , D ; θ ) P(r|U, D; θ) P(r∣U,D;θ)生成响应r。

反应的形成可以分解为三个不相关的行为:

- 根据已经产生的内容选择一个词,使句子在语言上有效(对应于语言模型)

- 根据上下文选择一个词,使对话连贯(对应于上下文处理器)

- 根据额外的知识选择一个词,使对话有基础(对应于知识处理器)

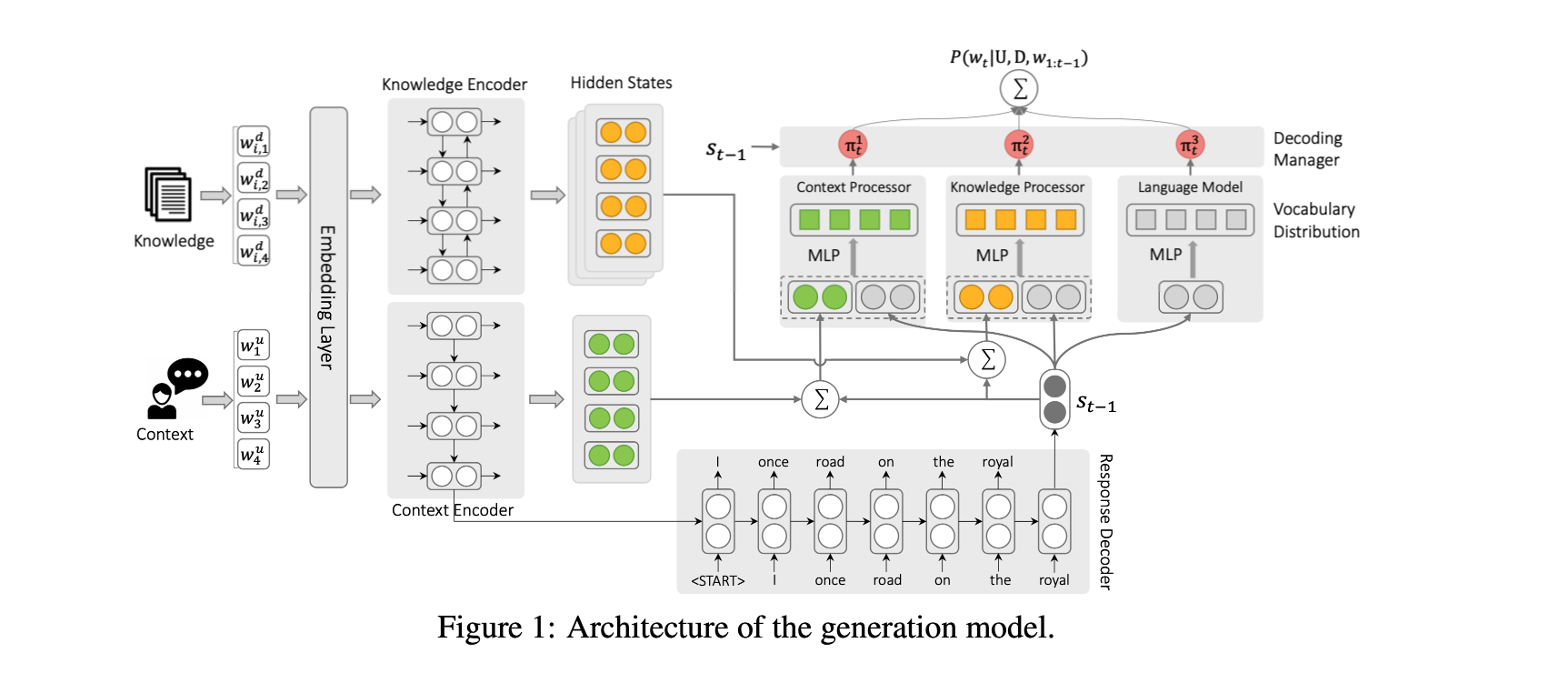

模型结构:*

组成:context encoder, knowledge encoder, decoder, decoding manager

解码器分解为语言模型、语境处理器和知识处理器。这三个部分的隐藏状态是独立的,由Manager协调。

ENCODERS

dialogue context使用GRU编码,将单词序列转化为隐藏层向量序列:

h 1 u , . . . , h i u , . . . , h l u u = G R U θ e ( e 1 u , . . . , e i u , . . . , e l u u ) , h^u_ 1, . . . , h^u_ i, . . . , h^u _{lu}= GRU_{θe}(e^u_ 1, . . . , e^u_ i, . . . , e^u_{lu}), h1u,…,hiu,…,hluu=GRUθe(e1u,…,eiu,…,eluu),

e 1 u e^u_ 1 e1u是 w 1 u w^u_ 1 w1u使用GloVe初始化的embedding。

document使用BiGRU编码:

h 1 d , . . . , h i d , . . . , h l d d = B i G R U θ k ( e i , 1 d , . . . , e i , j d , . . . , e i , l d d ) , h^d_ 1, . . . , h^d_ i, . . . , h^d _{ld}= BiGRU_{θk}(e^d_ {i,1}, . . . , e^d_ {i,j}, . . . , e^d_{i,ld}), h1d,…,hid,…,hldd=BiGRUθk(ei,1d,…,ei,jd,…,ei,ldd),

e i , j d e^d_{i,j} ei,jd是第j个单词使用GloVe初始化的embedding。

编码阶段没有进行knowledge selection,这可以消除上下文编码和知识编码之间的依赖性。

DISENTANGLED DECODER

解码器维护隐藏的序列 { s t } t = 1 l r \{s_t\}^{l_r}_{t=1} { st}t=1lr表示t-1步的单词预测embedding, s t s_t st定义为:

s t = G R U θ d ( e t − 1 r , s t − 1 ) s_t= GRU_{θd}(e^r_{ t−1}, s_{t−1}) st=GRUθd(et−1r,st−1)

DECODING MANAGER

三个decoder组件由解码管理器控制,在响应预测的每一步都有一个组件被拾起。

使用了一个Gumbel trick π t π_t πt,定义为:

π t = g u m b e l s o f t m a x ( f π ( s t − 1 ) , τ ) π_t= gumbel\ softmax(f_π(s_{t−1}), τ) πt=gumbel softmax(fπ(st−1),τ)

数据集

- Wizard of Wikipedia (Wizard)

- CMU Document Grounded Conversations(CMU DoG)

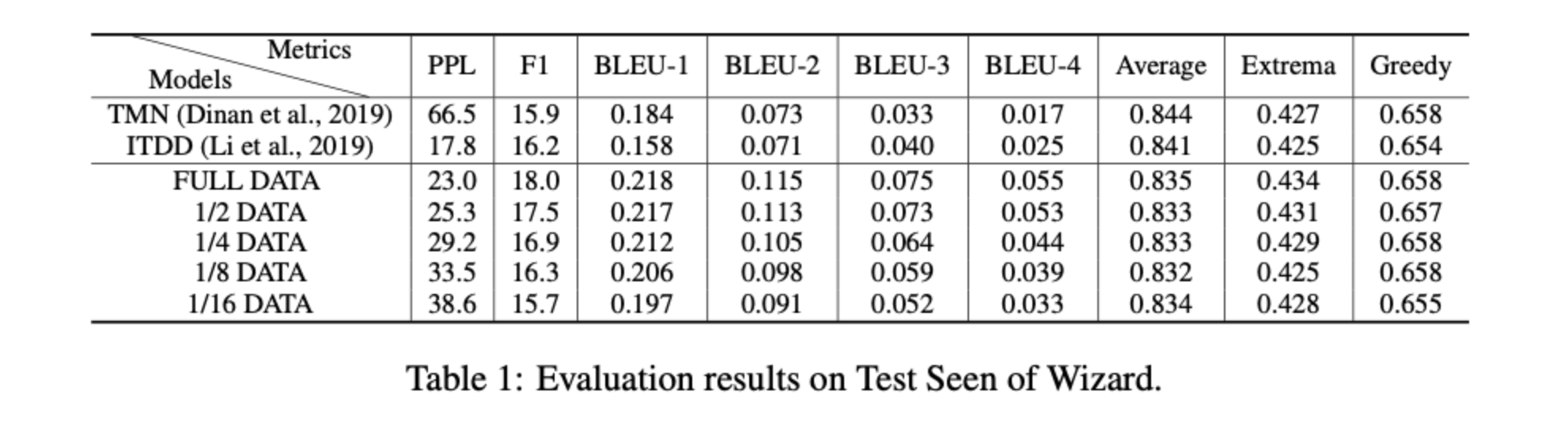

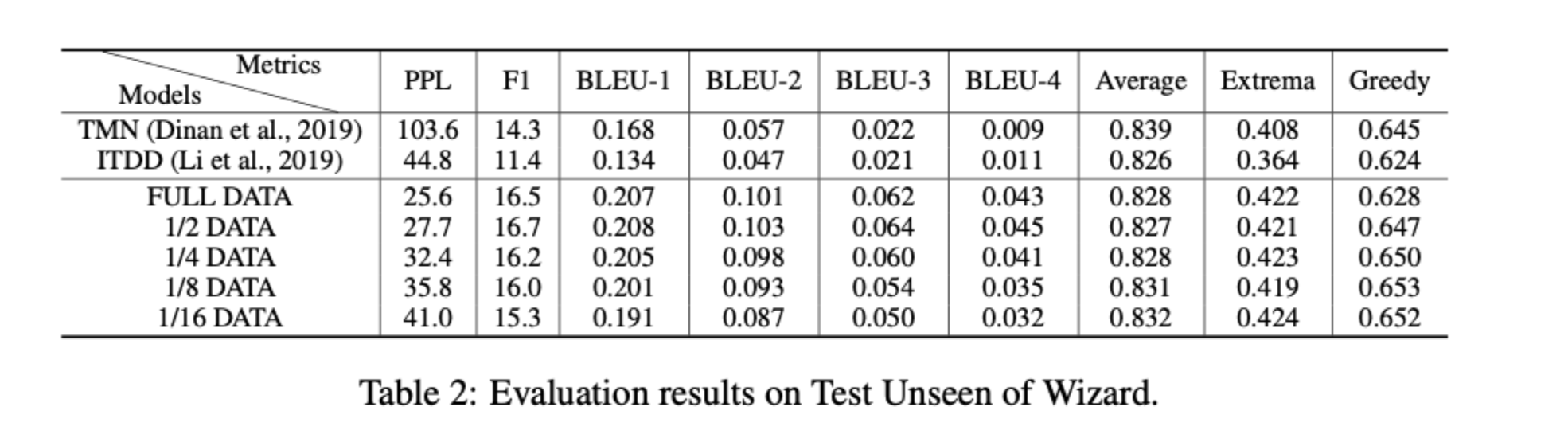

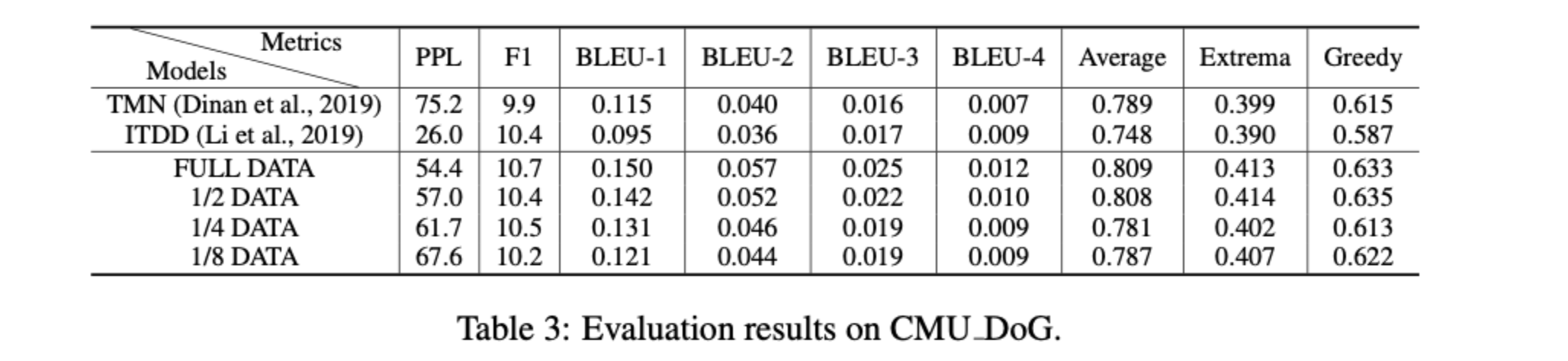

性能水平

- Wizard respectively

- CMU DoG

即使数据集缩小,Test Unseen性能相比于Test seen依然稳定,与基线模型相比Test Unseen性能提升更加显著。

ITDD在Test Seen和CMU DoG上都取得了较低的PPL,这可能是由于two_pass解码器的过度拟合。

结论

本文研究了在低资源环境下以知识为基础的对话生成。为了克服训练数据不足带来的挑战,将响应解码器分解为独立的组件,其中大部分参数不再依赖训练数据,可以从大规模的无基础对话和非结构化文档中估计出来。对两个基准的评估结果表明,模型在只有1/8的训练数据的情况下达到了最先进的性能,并且对领域外的知识表现出良好的泛化能力。

还没有评论,来说两句吧...