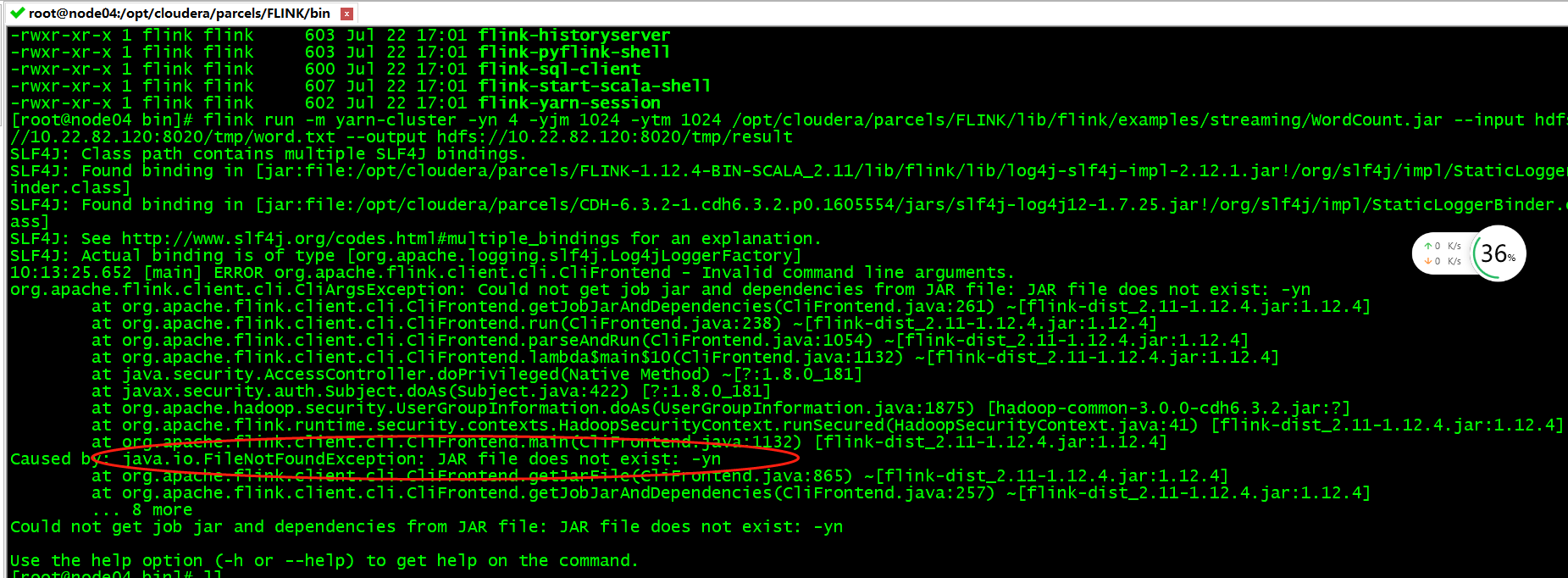

Flink 任务报错:flink FileNotFoundException: JAR file does not exist: -yn

如图:

原因:flink从1.10开始不再支持参数 -yn

解决:去掉参数 -yn执行

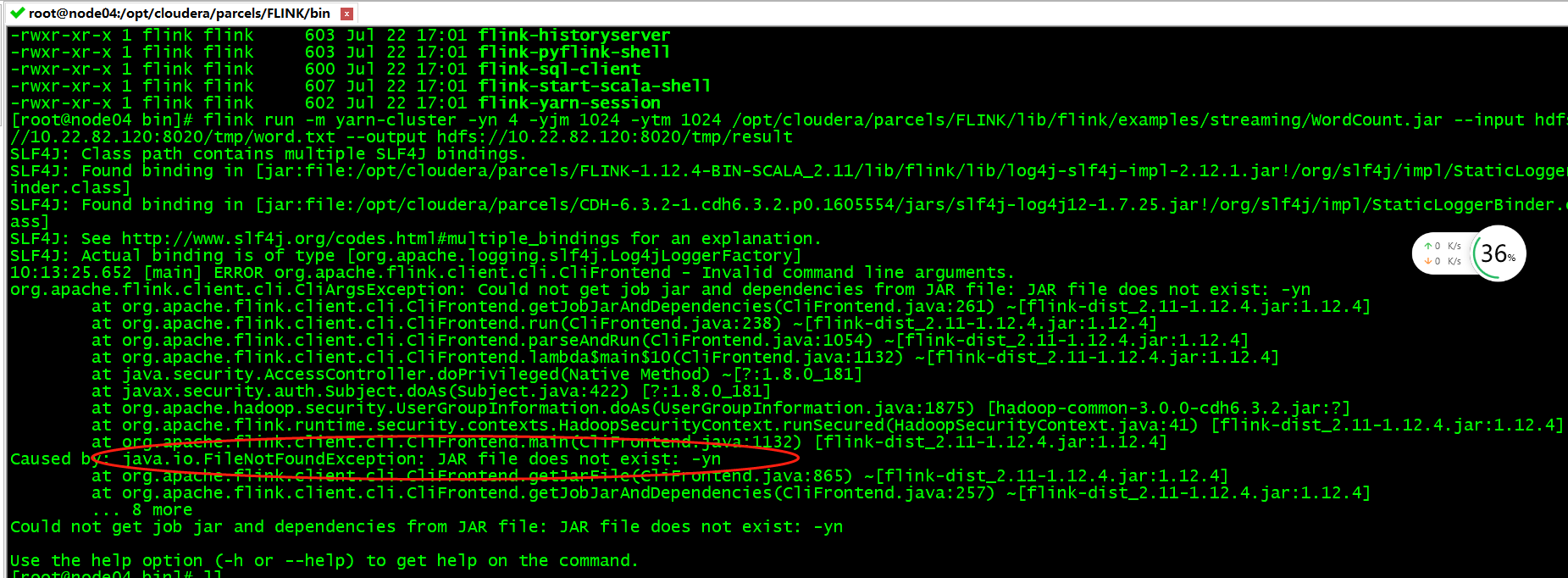

如图:

原因:flink从1.10开始不再支持参数 -yn

解决:去掉参数 -yn执行

错信息1: Error:(20, 36) could not find implicit value for evidence parameter of typ...

背景 linux centos7 hadoop 执行 hadoop jar 命令时,一直报错 解决方法 1、确定自己的jar目录是切实存在的,别弄错了

错误内容: ![20190618200320634.png][] 自己电脑是mac系统的。同事上传到git的代码是windows系统的。 在idea中执行 clean或i

![watermark_type_ZHJvaWRzYW5zZmFsbGJhY2s_shadow_50_text_Q1NETiBA56iL5bqP5ZGY5bCP5a6B_siz

文章目录 1.概述 地址:[https://blog.csdn.net/qq\_21383435/article/details/119742764][https

如图: ![watermark_type_ZmFuZ3poZW5naGVpdGk_shadow_10_text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3U

报错信息1: Error:(20, 36) could not find implicit value for evidence parameter of type

1、报错信息如下 org.apache.flink.client.program.ProgramInvocationException: The main method

不要带单引号!! hive> add jar '/abc/def.jar'; -- 报错 '/abc/def.jar' does not exist Query

起因: 配置kubernetes集群master高可用期间发现keepalived 配置健康检查后,启动报错。 报错内容 Keepalived_vrrp:

还没有评论,来说两句吧...