2.1.6 hadoop体系之离线计算-hdfs分布式文件系统-全分布式安装

目录

1.写在前面

2.安装条件

3.修改配置文件

3.1 修改hadoop-env.sh

3.2 修改core-site.xml文件

3.3 修改hdfs-site.xml

3.4 修改workers(从节点别名)

4.向node02,node03,node04分发安装hadoop

5.配置hadoop环境

6.主节点node01格式化当前NAMENODE节点-创建文件夹

7.在主节点node01上启动集群

7.1 打开node01监听端口:ss -nal

1.写在前面

之前在node01节点上搭建了一个伪分布式安装的hadoop,现在想利用我们手里的4台虚拟机,搭建一个4台主机的完全分布式的hadoop。

2.安装条件

需要安装jdk环境和ssh免秘钥登陆安装hadoop在:cd /opt/sxt/ 下面

3.修改配置文件

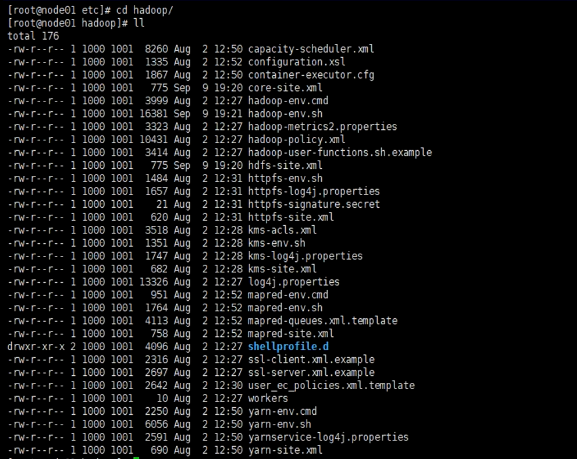

cd etc/hadoop 进入这个目录(集群启动的时候,只会读当前这个文件夹),其中有大量配置文件。

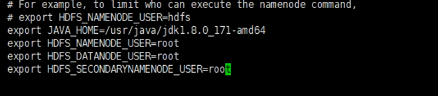

3.1 修改hadoop-env.sh

**直接启动 vi hadoop-en.sh,找到末尾,需要引入jdk环境变量,写上角色和对应进程,目前是需要三个角色:1个namenode+2个datanode。(一共四个配置项)**

echo $JAVA_HOME 可以输出路径

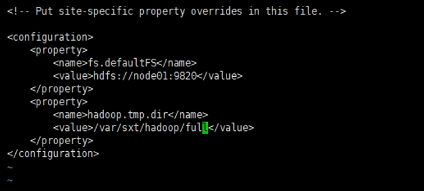

3.2 修改core-site.xml文件

直接启动 vi core-site.xml ,文件本身没有任何配置信息,需要手动填写进来。localhost修改为节点的别名,一般默认端口开启9820,修改临时目录。

<configuration><property><name>fs.defaultFS</name><value>hdfs://node01:9820</value></property><property><name>hadoop.tmp.dir</name><value>/var/sxt/hadoop/full</value></property></configuration>

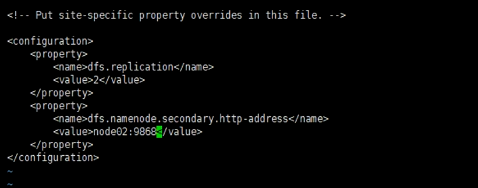

3.3 修改hdfs-site.xml

直接启动 vi hdfs-site.xml ,replication代表的是副本的意思,副本保证了高可用。

<configuration><property><name>dfs.replication</name><value>2</value></property><property><name>dfs.namenode.secondary.http-address</name><value>node02:9868</value></property></configuration>

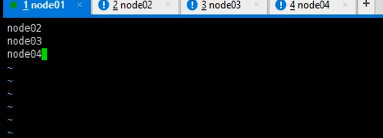

3.4 修改workers(从节点别名)

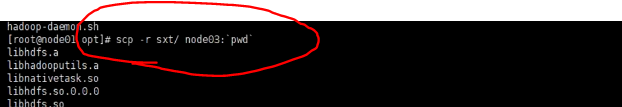

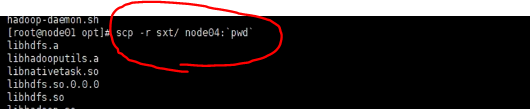

4.向node02,node03,node04分发安装hadoop

node02下面没有sxt文件夹,但是有opt,所以将sxt整个发给他们。

5.配置hadoop环境

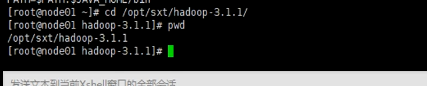

查找到hadoop所在文件夹:

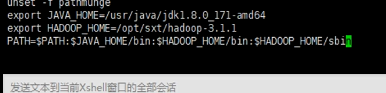

编译profile文件:vi + /etc/profile ,添加HADOOP\_HOME和PATH

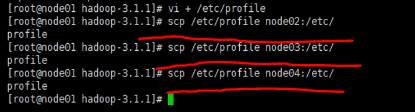

分发到其他三个节点:

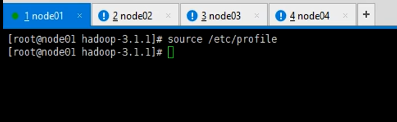

重读profile文件(四台机器都要做)

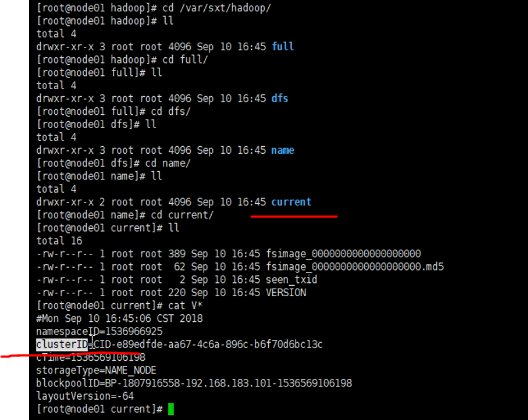

6.主节点node01格式化当前NAMENODE节点-创建文件夹

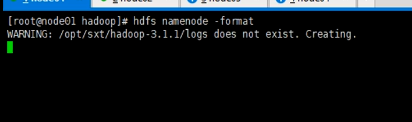

执行:hdfs namenode -format

查看最后执行结果:

文件夹下面也会多了一个集群的ID信息。

其他三个节点是没有这些文件的,因为我们只是在主节点上创建的。存放的就是元数据信息。

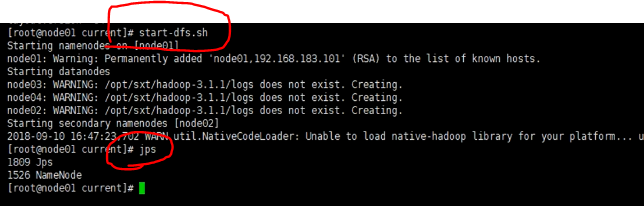

7.在主节点node01上启动集群

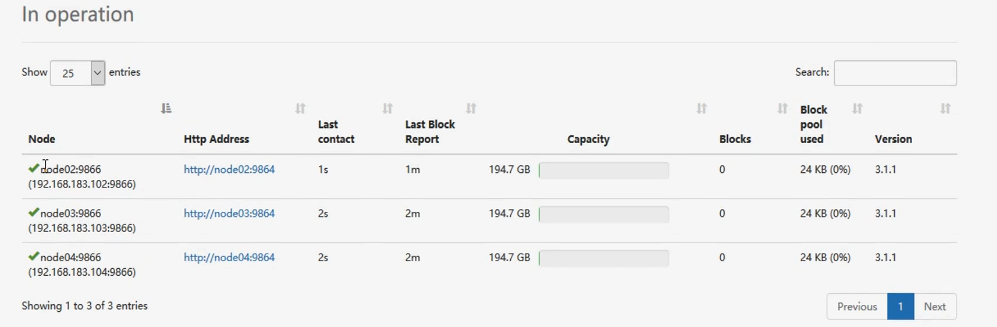

直接使用start-dfs.sh命令就可以启动:node01:namenodenode02:secondaryNamenode、datanodenode03:datanodenode04:datanode

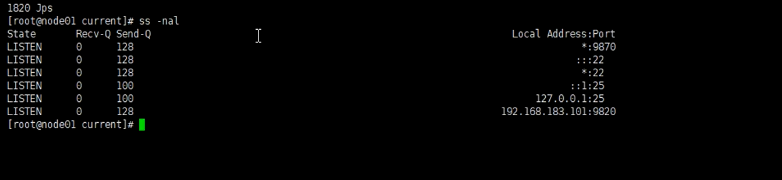

7.1 打开node01监听端口:ss -nal

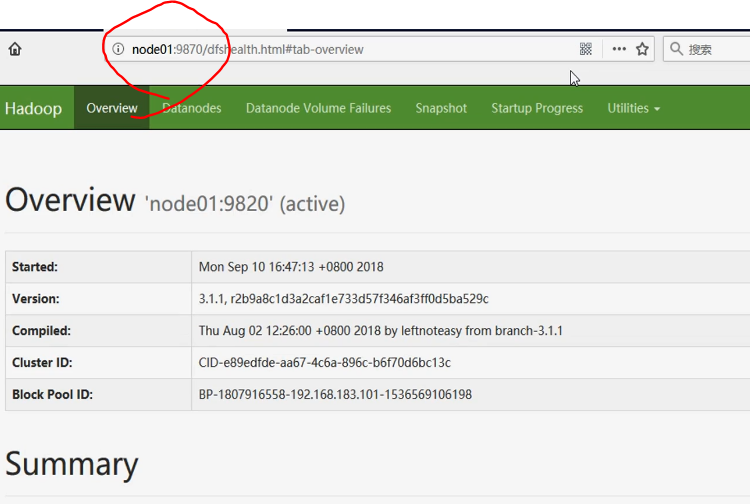

浏览器访问:node01:9870(192.138.0.101:9870)

有一个主节点NameNode用来存储元数据信息,还有文件持久化合并的secondaryNameNode,三个存放数据的从节点datanode。

还没有评论,来说两句吧...