Crawler入门

目录

Crawler入门

什么是Crawler?

Crawler的应用领域

Crawler的基础知识

Robots协议

HTTP请求

HTML解析

数据存储

Crawler入门指南

总结

Crawler入门

在互联网时代,信息爆炸的背景下,爬虫(Crawler)逐渐成为了获取和分析互联网上大量数据的重要工具。本篇博客将介绍Crawler的基础知识和入门指南。

什么是Crawler?

Crawler,又称网络爬虫或网络蜘蛛,是一种自动化程序,用于模拟人类对网页进行访问和抓取数据。Crawler通过HTTP协议发送请求到目标网站,并解析网页内容提取所需数据。

Crawler的应用领域

Crawler在多个领域有广泛的应用,例如:

- 搜索引擎:Crawler是搜索引擎的核心技术,它可以自动抓取互联网上的网页,并构建索引以便用户进行搜索。

- 数据分析:Crawler可以帮助企业或研究者获取大量的数据进行分析,从而支持决策和洞察。

- 价格比较:Crawler可以抓取各个电商网站上的商品信息,帮助用户对比价格和评价,以便做出更好的购物决策。

- 舆情监测:Crawler可以抓取新闻网站、社交媒体等渠道上的文章和评论,进行情感分析和舆情监测。

- 自动化测试:Crawler可以模拟用户行为,对网站进行功能和性能测试。

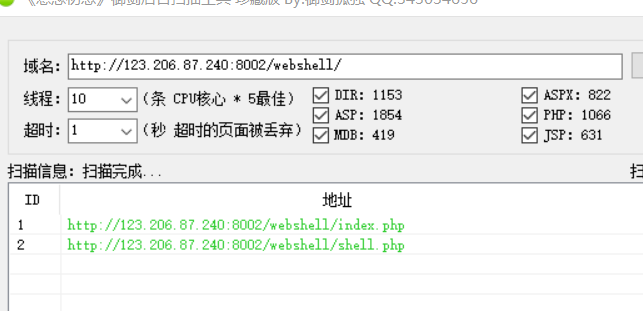

- 网络安全:Crawler可以帮助发现网站的漏洞和安全问题。

Crawler的基础知识

1. Robots协议

Robots协议是网站用来告诉Crawler哪些页面可以抓取的协议。在爬取网站数据之前,需要查看并遵守网站的Robots协议,以避免侵犯隐私和法律问题。

2. HTTP请求

Crawler通过HTTP请求获取网页内容。HTTP请求包括请求方法(GET、POST等)、请求头(Headers)和请求体(Body)。可以使用各种编程语言中的HTTP库来发送HTTP请求。

3. HTML解析

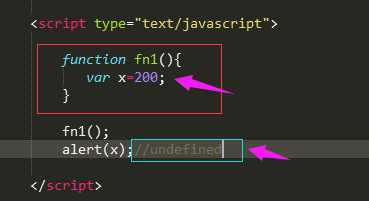

Crawler需要解析HTML文档以提取数据。可以使用HTML解析器解析HTML文档,并使用XPath或CSS选择器等方式来定位和提取需要的数据。

4. 数据存储

Crawler可以将抓取的数据存储到数据库或文件中,以供后续分析和使用。常见的数据存储方式包括CSV、JSON和数据库(MySQL、MongoDB等)。

Crawler入门指南

以下是一个简单的Crawler入门指南,帮助你快速上手:

- 确定需求:明确你需要抓取的数据类型和数据源,并分析目标网站的结构和Robots协议。

- 选择开发语言:根据需求选择适合的编程语言和Crawler库,例如Python的Scrapy、Node.js的Puppeteer等。

- 配置环境:安装所选开发语言的相关工具和库,并创建项目目录。

- 编写代码:根据目标网站的结构和需求,编写Crawler的代码。代码主要包括发送HTTP请求、解析HTML文档和存储数据。

- 测试和调试:运行Crawler,并确保数据抓取和解析的正确性。如果出现问题,可以使用调试工具和日志来分析和解决问题。

- 优化性能:对Crawler的性能进行优化,例如使用多线程或异步请求来提高抓取速度,设置合适的请求频率以避免对目标网站造成过大的负担。

- 监控和维护:定期监控Crawler的运行情况,并根据需要进行维护和更新。

总结

Crawler是获取和分析互联网上大量数据的重要工具,在数据科学和业务决策中发挥着重要作用。通过学习Crawler的基础知识和入门指南,你可以快速入门并掌握Crawler的使用技巧。希望这篇文章对你有所帮助!

当我们使用Python语言的Scrapy库来实现一个简单的爬虫,以爬取某个电商网站的商品信息为例。 首先,我们需要安装Scrapy库。在命令行中执行以下命令:

plaintextCopy codepip install scrapy

然后,我们创建一个新的Scrapy项目。在命令行中执行以下命令:

plaintextCopy codescrapy startproject ecommerce_crawlercd ecommerce_crawler

接下来,我们创建一个爬虫的Spider。在命令行中执行以下命令:

plaintextCopy codescrapy genspider products example.com

打开新生成的products.py文件,并编辑代码,如下所示:

pythonCopy codeimport scrapyclass ProductsSpider(scrapy.Spider):name = 'products'allowed_domains = ['example.com']start_urls = ['http://www.example.com/products']def parse(self, response):# 解析页面,提取商品信息for product in response.xpath('//div[@class="product"]'):title = product.xpath('a/text()').get()price = product.xpath('span[@class="price"]/text()').get()yield {'title': title,'price': price}# 获取下一页的URL并发送请求next_page = response.xpath('//a[@class="next-page"]/@href').get()if next_page:yield response.follow(next_page, self.parse)

以上代码的作用是定义一个名为products的Spider,并指定了抓取的起始URL为http://www.example.com/products。在parse方法中,我们使用XPath语法来解析页面,提取商品的标题和价格,并将它们以字典的形式yield出来。 最后,我们在命令行中运行爬虫。执行以下命令:

plaintextCopy codescrapy crawl products -o products.json

爬虫会开始抓取数据,并将结果保存在products.json文件中。 这只是一个简单的示例,实际的爬虫可能需要更复杂的处理逻辑和多个页面的抓取。Scrapy库提供了丰富的功能和扩展性,可以根据具体需要进行自定义配置和编写代码。

Crawler(爬虫)作为一种数据采集的工具,在实际应用中有一些缺点和类似的工具。以下是它们的详细介绍:

- 缺点: a. 依赖网站结构:爬虫程序通常需要与目标网站的结构相匹配,这意味着当网站的结构发生变化时,爬虫程序可能会失效,需要进行相应的调整与适配。

b. 爬取速度受限:爬虫程序需要通过发送HTTP请求并等待响应来获取网页数据,这个过程可能会受到网络速度、服务端限制等因素的影响,从而导致爬取速度受限。

c. 数据可靠性:由于目标网站的数据更新频率和内容变动性,爬虫程序有时候可能不能获取到最新、准确的数据,甚至会受到网站对爬虫的限制而无法正常工作。

d. 隐私和法律问题:爬虫程序在获取网站数据时,有可能侵犯网站的隐私和版权等法律问题,如果不合法或未经授权地使用爬虫,可能会面临法律风险。 - 类似的工具: a. API:API(Application Programming Interface)是一种通过特定请求和返回格式,提供数据和功能接口的方式。与爬虫不同,API是合法且经过授权的方式获取数据。许多网站提供API,让开发者可以按照规定的方式获取数据。

b. RSS 订阅:RSS(Rich Site Summary)或者是更常见的Feed是一种通过提供统一格式的XML数据,让用户可以轻松订阅和获取网站最新内容的方式。用户可以使用Feed阅读器来订阅自己感兴趣的网站,从而获取更新的文章、新闻等信息。

c. 数据源许可:一些网站和组织提供有偿或无偿的数据许可,使开发者可以合法地使用特定数据集。这种方式可以避免侵犯隐私和版权等法律问题,并获得更可靠的数据。

这些工具在特定的场景下可能更加适用,且遵循合法、经过授权的原则。但与爬虫相比,它们可能有一些限制,比如数据范围受限等。根据具体需求和合法的前提条件,选择合适的工具进行数据采集是重要的。

还没有评论,来说两句吧...