Python爬虫:如何避免被网站反爬措施限制?

在编写Python爬虫时,确实可能会遇到网站的反爬机制。以下是一些避免或者应对这些限制的方法:

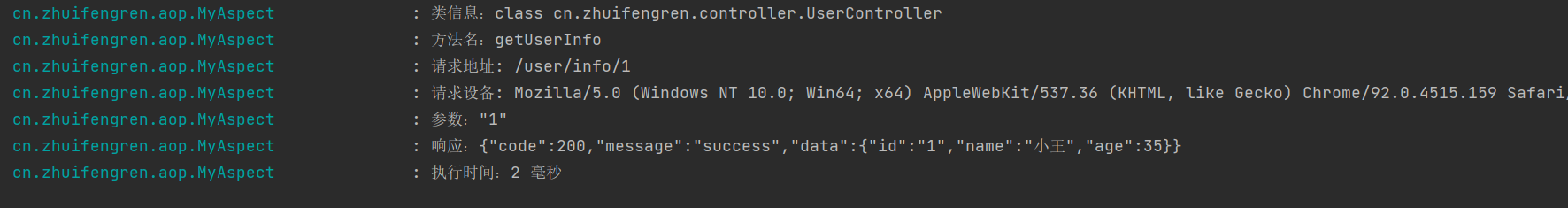

设置User-Agent:

部分网站会根据User-Agent来判断请求是否为爬虫。可以使用Python的requests库设置User-Agent。模拟浏览器行为:

爬虫应该尽可能地模仿真实用户的行为,比如点击按钮、填写表单等。设置请求间隔:

避免过于频繁的请求被网站认为是爬虫。使用代理IP:

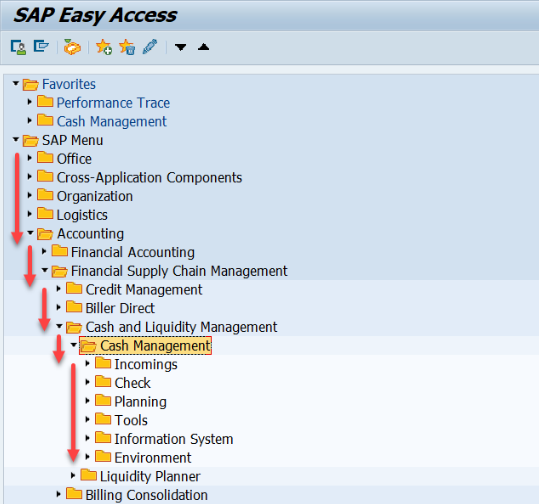

有时候直接访问会被限制,这时可以利用代理IP来提高抓取的成功率。尊重网站robots.txt:

网站通常会在根目录下放置一个名为robots.txt的文件,里面会列出该网站允许爬取的部分。

遵循以上原则,可以帮助你编写更稳定、不会轻易被反爬措施限制的Python爬虫。

还没有评论,来说两句吧...