从零搭建一个hadoop

从零搭建一个hadoop

- 配置ssh免密登陆

- 配置java环境变量

- 配置Hadoop环境变量

- 配置核心组件文件

- 配置文件系统

- 配置yarn

- 配置MapReduce计算框架文件

- 配置Master的slaves文件

- 复制Master上的hadoop到slave节点

- 格式化文件系统

- 启动和关闭hadoop

- 验证hadoop是否启动成功

配置ssh免密登陆

首先自己有2台主机,

给他设置好hostname

vi /etc/hosts

改成你需要的host 任意个.

然后需要设置一下ssh免密登陆

ssh-keygen -t rsa

一路按回车

cd /root/.ssh/

把刚刚生成的免密登陆复制到authorized_keys里面.

cat id_rsa.pub >> authorized_keys

需要在子系统做这些操作 让这些操作系统都可以免密登陆.

配置java环境变量

解压下载好的java后

vi /etc/profile

加入java的路径配置

export JAVA_HOME=/opt/wacos/tools/jdk8export PATH=$JAVA_HOME/bin:$PATH

然后

source /etc/profile

配置Hadoop环境变量

解压下载好的hadoop后

vi /etc/profile

加入java的路径配置

export HADOOP_HOME=/opt/wacos/hadoopexport PATH=$HADOOP_HOME/bin:$PATH

然后

source /etc/profile

接下来

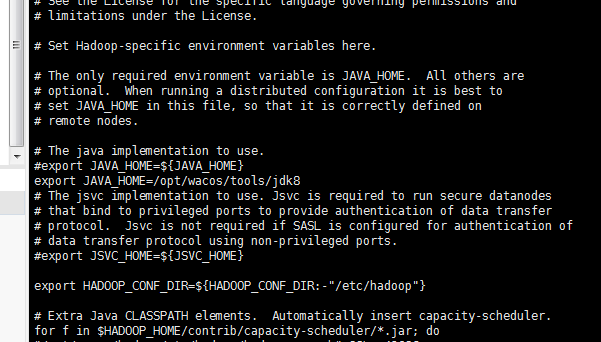

vi /opt/wacos/hadoop/etc/hadoop/hadoop-env.sh

把里面的export JAVA_HOME换成你当前的java路径.

配置核心组件文件

vi /opt/wacos/hadoop/etc/hadoop/core-site.xml

需要将下面的配置代码放在文件中的configuration之间

<property><name>fs.defaultFS</name><value>hdfs://ut102:9000</value></property><property><name>hadoop.tmp.dir</name><value>/opt/wacos/hadoopdata</value></property>

这里注意要在所有节点进行创建目录,目录的地址是hadoop.tmp.dir

mkdir /opt/wacos/hadoopdata

配置文件系统

vi /opt/wacos/hadoop/etc/hadoop/hdfs-site.xml

需要将下面的配置代码放在文件中的configuration之间

<property><name>dfs.replication</name><value>1</value></property>

配置yarn

vi /opt/wacos/hadoop/etc/hadoop/yarn-site.xml

需要将下面的配置代码放在文件中的configuration之间

<property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.resourcemanager.address</name><value>ut102:18040</value></property><property><name>yarn.resourcemanager.scheduler.address</name><value>ut102:18030</value></property><property><name>yarn.resourcemanager.resource-tracker.address</name><value>ut102:18025</value></property><property><name>yarn.resourcemanager.admin.address</name><value>ut102:18141</value></property><!-- Site specific YARN configuration properties --><property><name>yarn.resourcemanager.webapp.address</name><value>ut102:18088</value><!-- This port defaults to 8088 --></property>

配置MapReduce计算框架文件

系统已有了一个mapred-site.xml.template 文件,我们需要将其改名

命令是

mv mapred-site.xml.template mapred-site.xml

然后编辑

vi /opt/wacos/hadoop/etc/hadoop/mapred-site.xml

需要将下面的配置代码放在文件中的configuration之间

<property><name>mapreduce.framework.name</name><value>yarn</value></property>

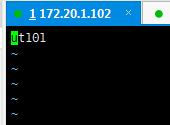

配置Master的slaves文件

vi /opt/wacos/hadoop/etc/hadoop/slaves

将自己的slave的ip或者是hostname放入slaves中 如图

复制Master上的hadoop到slave节点

scp -r /opt/wacos/hadoop root@ut101:/opt/wacos/hadoop

格式化文件系统

该操作只需要在Master节点进行,命令是

hdfs namenode -format

启动和关闭hadoop

完成上述准备即可启动hadoop了,

./opt/wacos/hadoop/sbin/start-all.sh

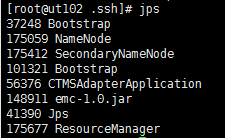

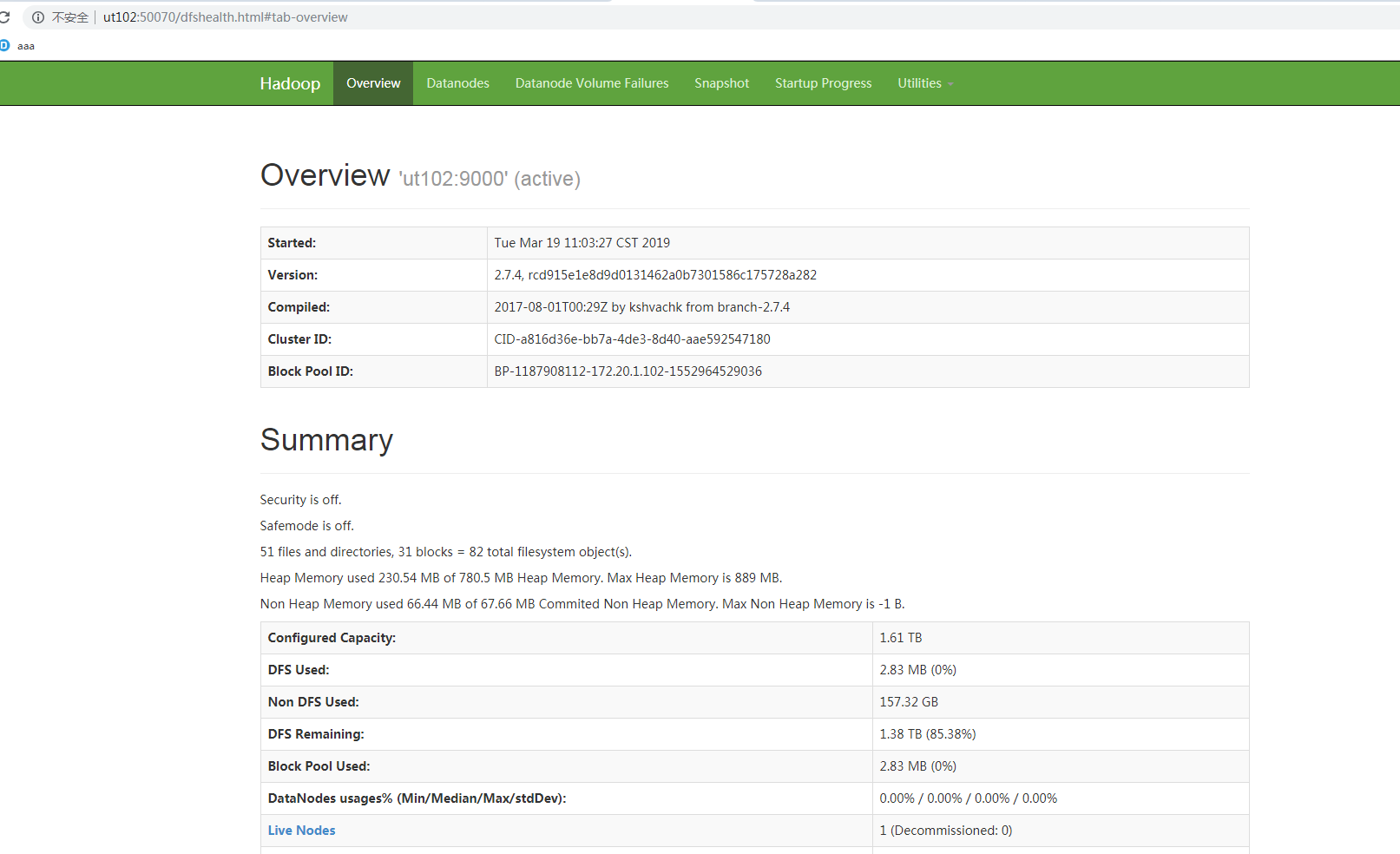

验证hadoop是否启动成功

使用 jps 命令

查看secondaryNameNode,ResourceManager,NameNode

有这3个进程就是启动成功.

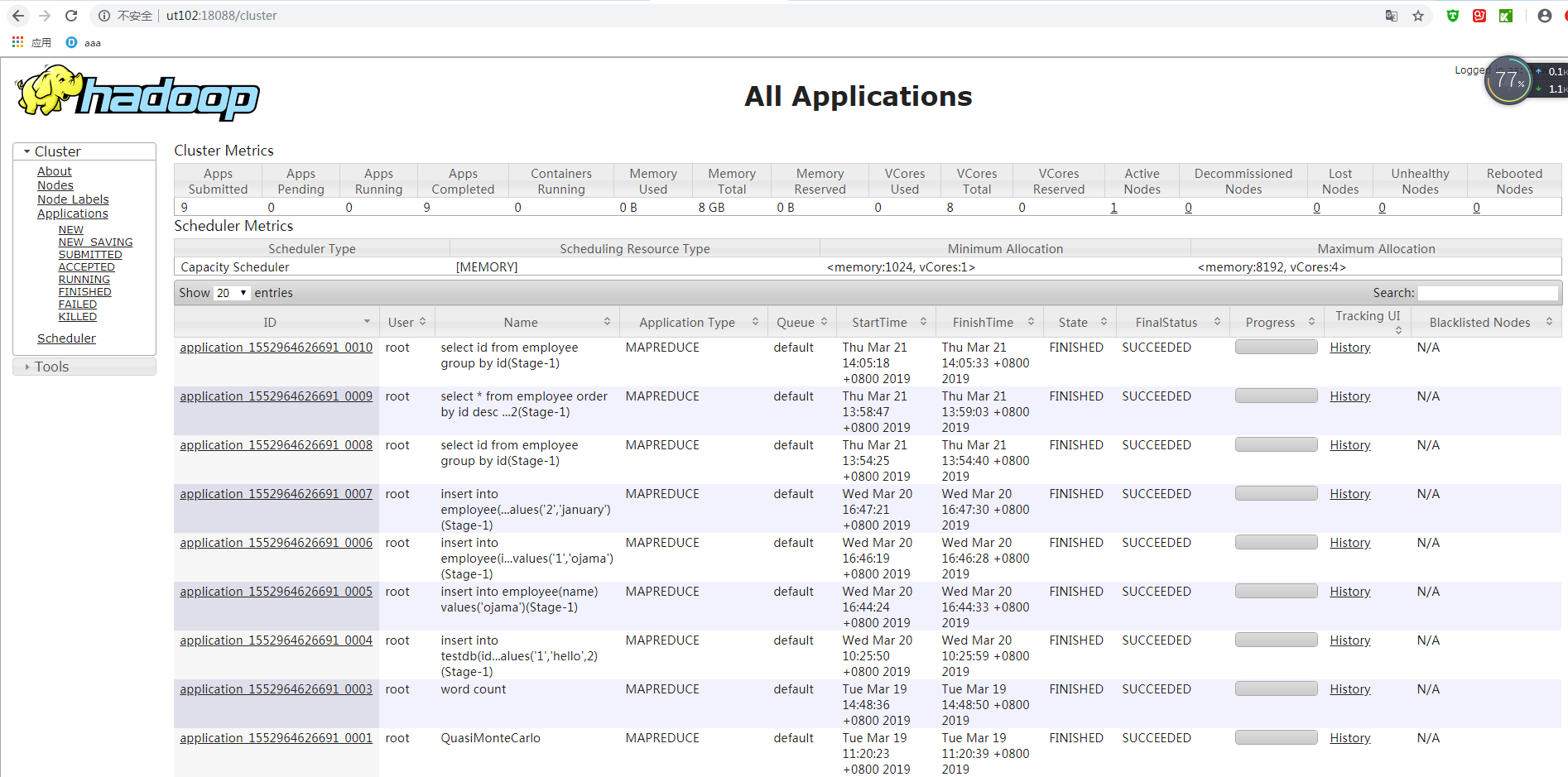

在浏览器上输入ut102:18088,可以检查Yarn的运行情况

整个安装过程就在这里结束了.

还没有评论,来说两句吧...