基于拓扑的增量学习Topology Preserving Class-Incremental learning论文详解ECCV2020

ECCV 2020

论文地址:https://doi.org/10.1007/978-3-030-58529-7_16

代码地址:论文中称,代码 will be released

西交大发表的。单看标题推测是运用Graph和拓扑学的知识来进行增量学习。基于正则化的增量学习方法。近两年很多论文都有类似想法,就是将CNN与Graph相结合来进行增量学习,用CNN提取模型特征,获得embedding信息,Graph网络用于学习特征之间的拓扑关系。

CVPR2020 ,FSCIL Few-shot Class Incremental Learning。将NG网络运用到增量学习之中。

ECCV2020,TPCIL,本篇,Topology Preserving Class-Incremental learning,同样的框架,即CNN+拓扑结构,部分内容换了一个写法。

CVPR2021与本篇非常类似,Few-Shot Incremental Learning with Continually Evolved Classifiers,南洋理工大学提出,也是运用Graph的知识,将GAT(Graph Attention Network)用于增量学习。

近期不少将Graph模型用于增量学习的,效果都不错,均取得了SOTA结果。并且Graph在增量的运用较新,加入一定的可解释性,很好发论文。

目录

1.贡献点

2.方法

2.1总体方法

2.2 EHG(Elastic Hebbian Graph)

3.实验

- 结论

1.贡献点

本文提出了Topology Preserving Class Incremental Learning(TPCIL)框架,

运用 Elastic Hebbian Graph (EHG)来进行feature域的建模

运用Topology-preserving loss(TPL)促进EHG的学习。

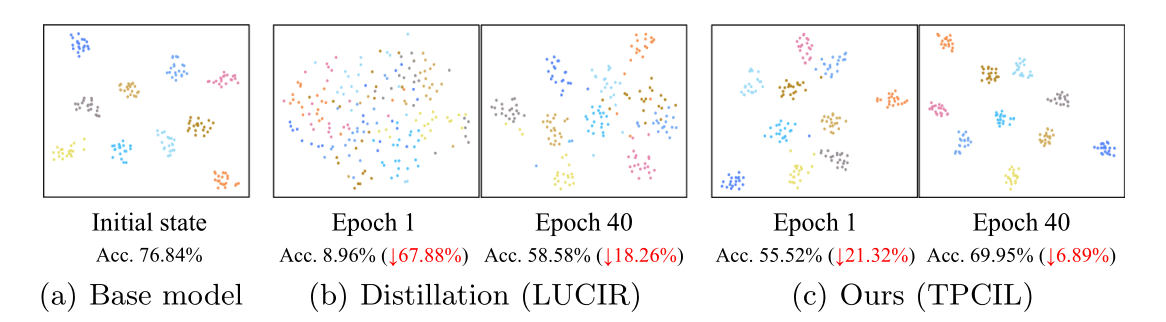

直观来看,TPL对于学习的促进:

经过40个epoch的训练,TPCIL比LUCIR样本的feature获得了更高的收敛程度。

2.方法

2.1总体方法

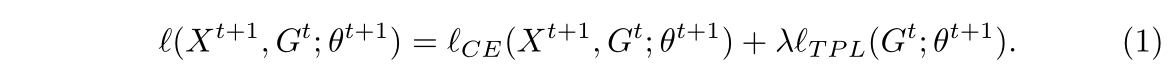

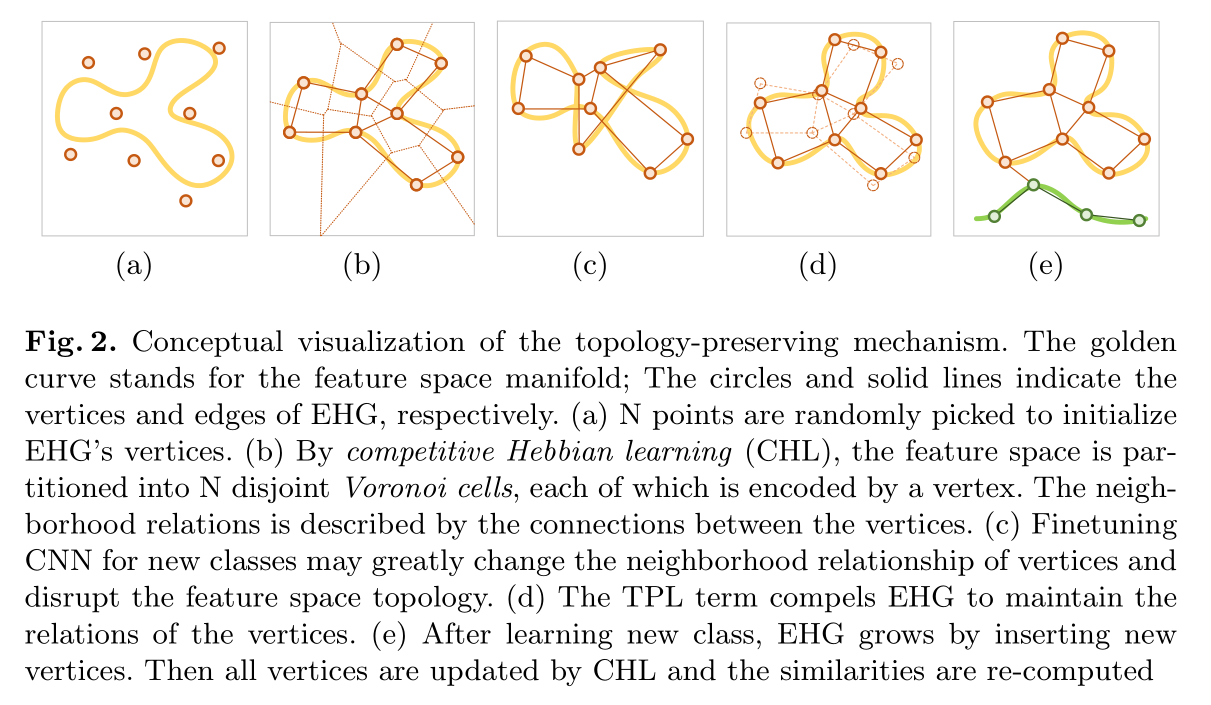

本文总体框架较为简单,相当于一个CNN加一个图模型G,G就是本文贡献点的Graph模型EHG(Elastic Hebbian Graph). Loss运用交叉熵和TPL相结合,TPL(Topology-Preserving)即用于训练G的loss,

交叉熵CE用于根据task t的样本X训练CNN参数和图模型G,TPL用于训练G和CNN。

对于EHG和CHL的作用粗略如下图所示:

对于EHG和CHL的作用粗略如下图所示:

- a 表示N个点的初始化的EHG,

- b 通过CHL,图形成了节点与节点之间的连接关系

- c 对CNN进行finetune,改变了特征空间上的点的位置

- d 但是TPL和EHG依然保持着之前的拓扑关系

- e 学习新类,则EHG会增加新的拓扑节点与链接关系

2.2 EHG(Elastic Hebbian Graph)

本文为了建模方便,将feture space的特征转化到cosine空间。上划线表示正则化操作,转化为单位向量。EHG的公式如下:

此公式跟FSCIL的公式(Few-Shot Class-Incremental Learning,CVPR2020的公式一模一样。)意义就是新样本到来之后,用新样本更新所有的节点,越近的节点更新越多,越远的节点更新越少。文中涉及一些graph模型的推导,因此对graph不太熟悉,所以我在此将其跳过,只留下重点的结论。

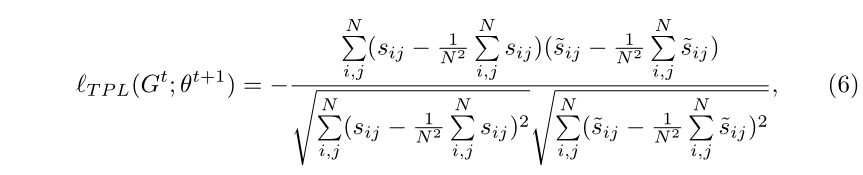

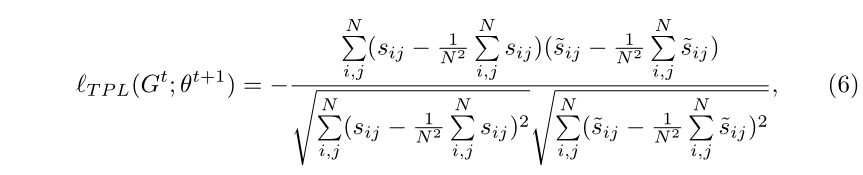

文中所提的TPL(Topology-preserving Loss)经过推导后如下:

其中

sij 可以理解为样本i

可以理解为样本i 和样本j

和样本j 经过模型特征提取后在特征空间的余弦距离。sij

经过模型特征提取后在特征空间的余弦距离。sij 表示初始的余弦距离,sij

表示初始的余弦距离,sij 表示增量任务t

表示增量任务t 到来之后的余弦距离。TPL可以粗略的理解为,旧的i

到来之后的余弦距离。TPL可以粗略的理解为,旧的i 和j

和j 之间的关系和新的i

之间的关系和新的i 和j

和j 之间的关系尽可能接近。从而保持拓扑结构的稳定。

之间的关系尽可能接近。从而保持拓扑结构的稳定。

因为博主没有其他公式推导的部分,对这个Graph网络了解也不多,所以公式的物理意义方面理解的不透彻。

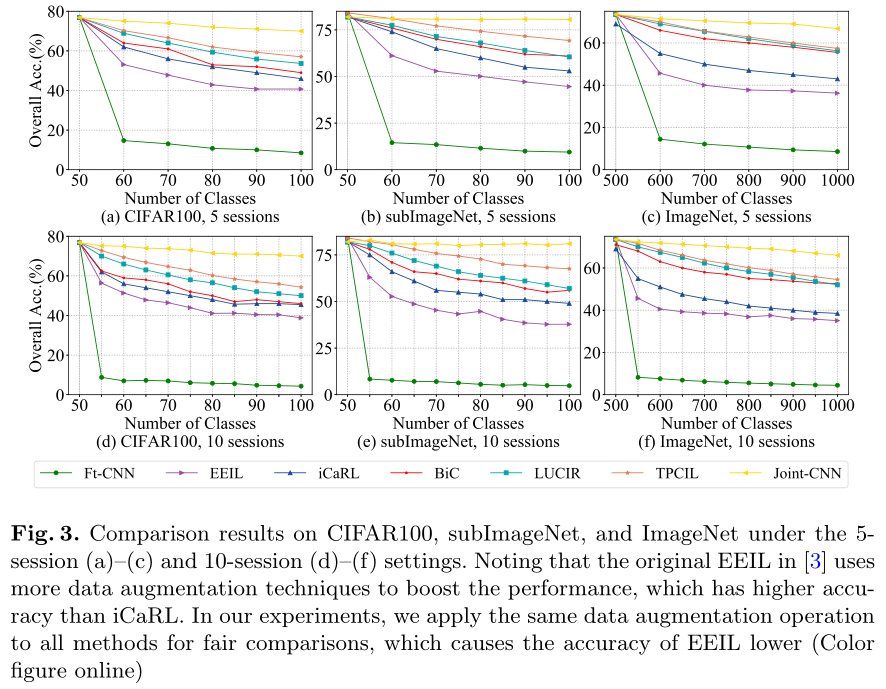

3.实验

可见本文方法优于其他同类的方法,仅次于联合训练。

4. 结论

思路:CNN+Graph模型

CNN提取特征,Graph模型提取模型之间的拓扑关系。

此思路作者发过一篇CVPR2020,经过变换又投了ICCV2020.

CVPR2020 ,FSCIL Few-shot Class Incremental Learning。将NG网络运用到增量学习之中。

ECCV2020,TPCIL,本篇,Topology Preserving Class-Incremental learning,同样的框架,即CNN+拓扑结构,部分内容换了一个写法。

CVPR2021与本篇非常类似,Few-Shot Incremental Learning with Continually Evolved Classifiers,南洋理工大学提出,也是运用Graph的知识,将GAT(Graph Attention Network)用于增量学习。

近期不少将Graph模型用于增量学习的,效果都不错,均取得了SOTA结果。并且Graph在增量的运用较新,加入一定的可解释性,很好发论文。

![[C#版剑指offer]旋转数组的最小数字查询 [C#版剑指offer]旋转数组的最小数字查询](https://image.dandelioncloud.cn/dist/img/NoSlightly.png)

还没有评论,来说两句吧...