yoloV3训练自己数据

目录

一、下载YOLO3项目

二、修改makefile配置

三、准备数据集

四、下载预训练权重(未实验)

五、修改3个配置文件

1、cfg/voc.data

2、data/voc.name

3、cfg/yolov3-voc.cfg

六、训练

七、关于训练时打印的日志详解

八、测试

一、下载YOLO3项目

git clone https://github.com/pjreddie/darknetcd darknet

在 darknet目录下创建 backup 文件夹,后面会用到。

二、修改makefile配置

具体配置参数说明参考:Darknet yolov3 Makefile文件解析

GPU=1CUDNN=1OPENCV=0OPENMP=0DEBUG=0ARCH= -gencode arch=compute_30,code=sm_30 \-gencode arch=compute_35,code=sm_35 \-gencode arch=compute_50,code=[sm_50,compute_50] \-gencode arch=compute_52,code=[sm_52,compute_52]# -gencode arch=compute_20,code=[sm_20,sm_21] \ This one is deprecated?# This is what I use, uncomment if you know your arch and want to specify# ARCH= -gencode arch=compute_52,code=compute_52VPATH=./src/:./examplesSLIB=libdarknet.soALIB=libdarknet.aEXEC=darknetOBJDIR=./obj/CC=gccCPP=g++NVCC=/usr/local/cuda/bin/nvccAR=arARFLAGS=rcsOPTS=-OfastLDFLAGS= -lm -pthreadCOMMON= -Iinclude/ -Isrc/CFLAGS=-Wall -Wno-unused-result -Wno-unknown-pragmas -Wfatal-errors -fPICifeq ($(OPENMP), 1)CFLAGS+= -fopenmpendififeq ($(DEBUG), 1)OPTS=-O0 -gendifCFLAGS+=$(OPTS)ifeq ($(OPENCV), 1)COMMON+= -DOPENCVCFLAGS+= -DOPENCVLDFLAGS+= `pkg-config --libs opencv` -lstdc++COMMON+= `pkg-config --cflags opencv`endififeq ($(GPU), 1)COMMON+= -DGPU -I/usr/local/cuda/include/CFLAGS+= -DGPULDFLAGS+= -L/usr/local/cuda/lib64 -lcuda -lcudart -lcublas -lcurandendififeq ($(CUDNN), 1)COMMON+= -DCUDNNCFLAGS+= -DCUDNNLDFLAGS+= -lcudnnendifOBJ=gemm.o utils.o cuda.o deconvolutional_layer.o convolutional_layer.o list.o image.o activations.o im2col.o col2im.o blas.o crop_layer.o dropout_layer.o maxpool_layer.o softmax_layer.o data.o matrix.o network.o connected_layer.o cost_layer.o parser.o option_list.o detection_layer.o route_layer.o upsample_layer.o box.o normalization_layer.o avgpool_layer.o layer.o local_layer.o shortcut_layer.o logistic_layer.o activation_layer.o rnn_layer.o gru_layer.o crnn_layer.o demo.o batchnorm_layer.o region_layer.o reorg_layer.o tree.o lstm_layer.o l2norm_layer.o yolo_layer.o iseg_layer.o image_opencv.oEXECOBJA=captcha.o lsd.o super.o art.o tag.o cifar.o go.o rnn.o segmenter.o regressor.o classifier.o coco.o yolo.o detector.o nightmare.o instance-segmenter.o darknet.oifeq ($(GPU), 1)LDFLAGS+= -lstdc++OBJ+=convolutional_kernels.o deconvolutional_kernels.o activation_kernels.o im2col_kernels.o col2im_kernels.o blas_kernels.o crop_layer_kernels.o dropout_layer_kernels.o maxpool_layer_kernels.o avgpool_layer_kernels.oendifEXECOBJ = $(addprefix $(OBJDIR), $(EXECOBJA))OBJS = $(addprefix $(OBJDIR), $(OBJ))DEPS = $(wildcard src/*.h) Makefile include/darknet.hall: obj backup results $(SLIB) $(ALIB) $(EXEC)#all: obj results $(SLIB) $(ALIB) $(EXEC)$(EXEC): $(EXECOBJ) $(ALIB)$(CC) $(COMMON) $(CFLAGS) $^ -o $@ $(LDFLAGS) $(ALIB)$(ALIB): $(OBJS)$(AR) $(ARFLAGS) $@ $^$(SLIB): $(OBJS)$(CC) $(CFLAGS) -shared $^ -o $@ $(LDFLAGS)$(OBJDIR)%.o: %.cpp $(DEPS)$(CPP) $(COMMON) $(CFLAGS) -c $< -o $@$(OBJDIR)%.o: %.c $(DEPS)$(CC) $(COMMON) $(CFLAGS) -c $< -o $@$(OBJDIR)%.o: %.cu $(DEPS)$(NVCC) $(ARCH) $(COMMON) --compiler-options "$(CFLAGS)" -c $< -o $@obj:mkdir -p objbackup:mkdir -p backupresults:mkdir -p results.PHONY: cleanclean:rm -rf $(OBJS) $(SLIB) $(ALIB) $(EXEC) $(EXECOBJ) $(OBJDIR)/*

保存后退出,在当前路径make一下。

三、准备数据集

在文件夹 darknet_sxp_anchor/scripts/VOC/ 下创建目录结构如下VOC————VOCdevkit————————VOC2019 #文件夹的年份可以自己取,但是要与你其他文件年份一致————————————Annotations #放入所有的xml文件————————————ImageSets————————————————Main #用于存放train.txt,val.txt,test.txt,trainval.txt文件。————————————JPEGImages #放入所有的图片文件————————————test.py #用于生成ImageSets/Main下的txt文件————————————labels #文件夹,由voc_label.py文件生成————voc_label.py #Main中的文件分别表示test.txt是测试集,train.txt是训练集,val.txt是验证集,trainval.txt是训练和验证集,

1、将图片处理成所需大小的图片

本文训练数据只有一个分类,使用如下脚本将原始数据处理成所需大小。然后将指定文件放在指定目录下

# -*- coding: utf-8 -*-import osimport cv2import hashlibimport numpy as npfrom xml.etree.ElementTree import parse, Element# list =#查找文件path=u"image_dir/"tag='camera_info'files=os.listdir(path)file_type=".jpg"imageSize=[832.0,832.0]#主逻辑#对于批量的操作,使用FOR循环for f in files:# try :#调试代码的方法:关键地方打上print语句,判断这一步是不是执行成功if f.endswith(file_type):imageFile=path+fimg=cv2.imdecode(np.fromfile(imageFile,dtype=np.uint8),cv2.IMREAD_COLOR)rateY=img.shape[0]/imageSize[0]rataX=img.shape[1]/imageSize[1]print ('rataX = {},rateY = {}'.format(rataX,rateY))xmlPath=imageFile.replace(file_type,".xml")dom=parse(xmlPath) ###最核心的部分,路径拼接,输入的是具体路径root=dom.getroot()image_info=root.find('size')image_info.find('width').text=str(int(imageSize[0]))image_info.find('height').text=str(int(imageSize[1]))tagobjs=root.findall('object')#.find('name')nameTag=root.find('object').find('name')nameTag.text=tagfor obj in tagobjs:box=obj.find('bndbox')box.find('xmin').text=str(int(int(box.find('xmin').text)/rataX))box.find('xmax').text=str(int(int(box.find('xmax').text)/rataX))box.find('ymin').text=str(int(int(box.find('ymin').text)/rateY))box.find('ymax').text=str(int(int(box.find('ymax').text)/rateY))dom.write(xmlPath, xml_declaration=True)img = cv2.resize(img,(int(imageSize[0]),int(imageSize[1])),interpolation=cv2.INTER_CUBIC)imageFile=imageFile.replace(file_type,".jpg")cv2.imencode('.jpg', img)[1].tofile(imageFile)# # except : print "error"###files=os.listdir(path)type=tagfile_type=".jpg"xml_file_type=".xml"#主逻辑#对于批量的操作,使用FOR循环for f in files:#调试代码的方法:关键地方打上print语句,判断这一步是不是执行成功if f.endswith(file_type):#找到老的文件所在的位置old_file=os.path.join(path,f)#指定新文件的位置,如果没有使用这个方法,则新文件名生成在本项目的目录中md5=hashlib.md5(old_file.encode("utf-8")).hexdigest()md5=str(md5).replace("raw","999")newName = type+"_"+md5+file_typenew_file=os.path.join(path,newName)os.rename(old_file,new_file)old_file=old_file.replace(file_type,".xml")#指定新文件的位置,如果没有使用这个方法,则新文件名生成在本项目的目录中newName = type+"_"+md5+xml_file_typenew_file=os.path.join(path,newName)print('old_file path ={},,new_file path = {}'.format( old_file,new_file))os.rename(old_file,new_file)

2、在 VOC2019 下创建 test.py 脚本,使用 test.py 脚本生成 Main 下的 txt 文件

import osimport randomtrainval_percent = 0.2train_percent = 0.8xmlfilepath = 'Annotations'txtsavepath = 'ImageSets\Main'total_xml = os.listdir(xmlfilepath)num = len(total_xml)list = range(num)tv = int(num * trainval_percent)tr = int(tv * train_percent)trainval = random.sample(list, tv)train = random.sample(trainval, tr)ftrainval = open('ImageSets/Main/trainval.txt', 'w+')ftest = open('ImageSets/Main/test.txt', 'w+')ftrain = open('ImageSets/Main/train.txt', 'w+')fval = open('ImageSets/Main/val.txt', 'w+')for i in list:name = total_xml[i][:-4] + '\n'if i in trainval:ftrainval.write(name)if i in train:ftest.write(name)else:fval.write(name)else:ftrain.write(name)ftrainval.close()ftrain.close()fval.close()ftest.close()

3、在 VOC 目录下创建 vol_label.py 脚本

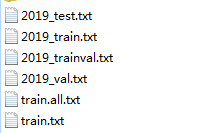

(1)该脚本会在与其同级目录下创建如下文件,产生的文件的内容是:

前四个txt文件:

- 数据集合与 ImageSets/Main 一 一对应

- 存放的是对应的图片的绝对路径

后两个txt文件:

前四个不同集合的并集,可以在vocI_label文件中修改

(2)该脚本也会在 /VOC/VOCdevkit/VOC2019 下创建文件夹 labels

用于存放 标签文件,格式如下

0 0.449074074074 0.679861111111 0.685185185185 0.456944444444说明:<object-class> <x> <y> <width> <height># encoding: utf-8"""@author: sunxianpeng@file: voc_label.py@time: 2019/11/20 14:23"""import xml.etree.ElementTree as ETimport pickleimport osfrom os import listdir, getcwdfrom os.path import join#这里要与Main中的txt文件一致sets = [('2019', 'train'), ('2019', 'trainval'), ('2019', 'val'), ('2019', 'test')]#你所标注的表签名,第一步中已经说过#classes = ["s","m","l","xl","xxl"]classes = ["camera_info"]def convert(size, box):dw = 1. / (size[0])dh = 1. / (size[1])x = (box[0] + box[1]) / 2.0 - 1y = (box[2] + box[3]) / 2.0 - 1w = box[1] - box[0]h = box[3] - box[2]x = x * dww = w * dwy = y * dhh = h * dhreturn (x, y, w, h)def convert_annotation(year, image_id):in_file = open('VOCdevkit/VOC%s/Annotations/%s.xml' % (year, image_id))out_file = open('VOCdevkit/VOC%s/labels/%s.txt' % (year, image_id), 'w')tree = ET.parse(in_file)root = tree.getroot()size = root.find('size')w = int(size.find('width').text)h = int(size.find('height').text)for obj in root.iter('object'):difficult = obj.find('difficult').textcls = obj.find('name').textif cls not in classes or int(difficult) == 1:continuecls_id = classes.index(cls)xmlbox = obj.find('bndbox')b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text),float(xmlbox.find('ymin').text),float(xmlbox.find('ymax').text))bb = convert((w, h), b)out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')wd = getcwd()for year, image_set in sets:if not os.path.exists('VOCdevkit/VOC%s/labels/' % (year)):os.makedirs('VOCdevkit/VOC%s/labels/' % (year))image_ids = open('VOCdevkit/VOC%s/ImageSets/Main/%s.txt' % (year, image_set))\.read().strip().split()list_file = open('%s_%s.txt' % (year, image_set), 'w')for image_id in image_ids:list_file.write('%s/VOCdevkit/VOC%s/JPEGImages/%s.jpg\n' % (wd, year, image_id))convert_annotation(year, image_id)list_file.close()print("xx")#意思是要将生成的文件合并,所以很据需要修改,这里的年份都是一致的,os.system("cat 2019_train.txt 2019_val.txt 2019_trainval.txt > train.txt")os.system("cat 2019_train.txt 2019_val.txt 2019_test.txt 2019_trainval.txt > train.all.txt")

四、下载预训练权重(未实验)

wget https://pjreddie.com/media/files/darknet53.conv.74

五、修改3个配置文件

1、cfg/voc.data

进入目录 /work/darknet_sxp_anchor/cfg

#classes为训练样本集的类别总数,第一步中说了我分了1类标签classes= 1#classes为训练样本集的类别总数,第一步中说了我分了1类标签train = /work/darknet_sxp_anchor/scripts/VOC/2019_train.txt#valid的路径为验证样本集所在的路径,上一步中生成valid = /work/darknet_sxp_anchor/scripts/VOC/2019_trainval.txt#names的路径为data/voc.names文件所在的路径names = data/voc.namesbackup = backup

2、data/voc.name

进入目录 /work/darknet_sxp_anchor/data

写入自己的分类名字,前后要对应

camera_info#s#m#l#xl#xxl#修改为自己样本集的标签名即第一步中标注的标签名

3、cfg/yolov3-voc.cfg

进入目录 /work/darknet_sxp_anchor/cfg

Ctrl + F 搜索 yolo,修改其上面的 filters 和其 下面的 classes,共三初地方

[net]# Testing#这里的batch跟subdivisions原来不是注释掉的,但是训练后没成功,有的blog上说为1的时候太小难以收#敛,但是不知道下面训练模式的 batch=64 subdivisions=8 会不会覆盖掉,总之注释掉后就成功了,不过#这个脚本不是很明白,还来不及验证# batch=1# subdivisions=1# Trainingbatch=64subdivisions=8......[convolutional]size=1stride=1pad=1filters=18 #---------------修改为3*(classes+5)即3*(5+5)=30activation=linear[yolo]mask = 6,7,8anchors = 10,13, 16,30, 33,23, 30,61, 62,45, 59,119, 116,90, 156,198, 373,326classes=1 #---------------修改为标签类别个数,5类num=9jitter=.3ignore_thresh = .5truth_thresh = 1random=0 #1,如果显存很小,将random设置为0,关闭多尺度训练;(转自别的blog,还不太明白)......[convolutional]size=1stride=1pad=1filters=18 #---------------修改同上activation=linear[yolo]mask = 3,4,5anchors = 10,13, 16,30, 33,23, 30,61, 62,45, 59,119, 116,90, 156,198, 373,326classes=1 #---------------修改同上num=9jitter=.3ignore_thresh = .5truth_thresh = 1random=0......[convolutional]size=1stride=1pad=1filters=18 #---------------修改同上activation=linear[yolo]mask = 0,1,2anchors = 10,13, 16,30, 33,23, 30,61, 62,45, 59,119, 116,90, 156,198, 373,326classes=1 #---------------修改同上num=9jitter=.3ignore_thresh = .5truth_thresh = 1random=0

六、训练

1、普通训练./darknet detector train cfg/voc.data cfg/yolov3-voc.cfg darknet53.conv.742、若想使用多个GPU训练./darknet detector train cfg/coco.data cfg/yolov3.cfg darknet53.conv.74 -gpus 0,1,2,3或者./darknet detector train cfg/voc.data cfg/yolov3-voc.cfg darknet53.conv.74 -gpus 0,1,2,33、如终止训练,权重会保存在backup文件夹下。如果要从检查点停止并重新启动训练./darknet detector train cfg/coco.data cfg/yolov3.cfg backup/yolov3.backup -gpus 0,1,2,3或者./darknet detector train cfg/voc.data cfg/yolov3-voc.cfg backup/yolov3.backup -gpus 0,1,2,3

七、关于训练时打印的日志详解

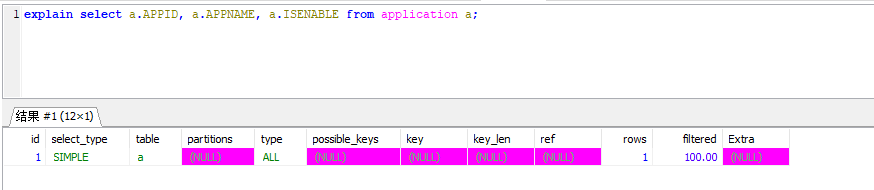

Region 82 Avg IOU: 0.874546, Class: 0.983519, Obj: 0.984566, No Obj: 0.008776, .5R: 1.000000, .75R: 0.750000, count: 4Region 94 Avg IOU: 0.686372, Class: 0.878314, Obj: 0.475262, No Obj: 0.000712, .5R: 1.000000, .75R: 0.200000, count: 5Region 106 Avg IOU: 0.893751, Class: 0.762553, Obj: 0.388385, No Obj: 0.000089, .5R: 1.000000, .75R: 1.000000, count: 1

三个尺度上预测不同大小的框,

- 82卷积层为最大预测尺度,使用较大的mask,可以预测出较小的物体。

- 94卷积层 为中间预测尺度,使用中等的mask。

106卷积层为最小预测尺度,使用较小的mask,可以预测出较大的物体。

Region 82 Avg IOU: 0.874546, Class: 0.983519, Obj: 0.984566,

No Obj: 0.008776, .5R: 1.000000, .75R: 0.750000, count: 4

Region Avg IOU: 表示在当前subdivision内的图片的平均IOU,代表预测的矩形框和真实目标的交集与并集之比。

- Class: 标注物体分类的正确率,期望该值趋近于1。

- Obj: 越接近1越好。

- No Obj: 期望该值越来越小,但不为零。

- count: count后的值是所有的当前subdivision图片中包含正样本的图片的数量。

八、测试

cd /work/darknet_sxp_anchor/./darknet detect cfg/yolov3.cfg yolov3.weights data/one.jpg./darknet detect cfg/yolov3-voc-test.cfg backup/yolov3-voc.backup scripts/VOC/VOCdevkit/VOC2019/JPEGImages/name.jpg./darknet detect cfg/yolov3-voc-test.cfg backup/yolov3-voc.backup scripts/VOC/VOCdevkit/VOC2019/JPEGImages/name.jpg -gpus 2

还没有评论,来说两句吧...