RuntimeError: Attempting to deserialize object on CUDA device 1 but torch.cuda.device_count() is 1.

出现这样的原因是因为我用了第二块GPU训练,在另一台机器上加载模型的时候,没有了第二块GPU,这时候就要指定用“cuda:0”torch.load('./modelSubmit/encoder_48.pth.tar',map_location='cuda:0')

然后加载模型就正常了。

出现这样的原因是因为我用了第二块GPU训练,在另一台机器上加载模型的时候,没有了第二块GPU,这时候就要指定用“cuda:0”torch.load('./modelSubmit/encoder_48.pth.tar',map_location='cuda:0')

然后加载模型就正常了。

目录 讲解Attempting to deserialize object on a CUDA device but torch.cuda.is\_available() i

详细的报错信息如下: RuntimeError: Expected all tensors to be on the same device, but fo

一般有三点错误 device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu") 1、

问题描述 运行程序时出现报错: RuntimeError: CUDA error: no kernel image is available for execu

RuntimeError: CUDA error: device-side assert triggered 报错信息 Traceback (most re

原因 报错的原因是,在pytorch中做损失函数计算时,标签为(batch,height,width),如果类别为10类,那么其中的值应该 为 0~9,即: 0<=

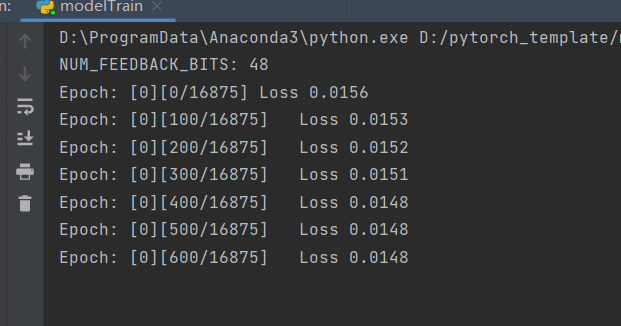

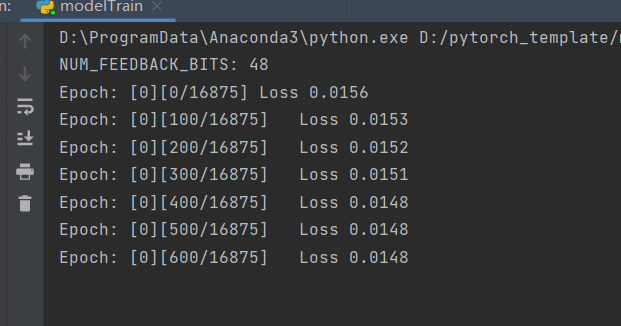

出现这样的原因是因为我用了第二块GPU训练,在另一台机器上加载模型的时候,没有了第二块GPU,这时候就要指定用“cuda:0” torch.load('./mo

在运行cuda程序时发生报错,出现 RuntimeError: CUDA error (10): invalid device ordinal 造成这个错误的原因主要是

问题: anchor_label = np.array(self.id_dict[int(anchor_id)]) identity_loss

两张卡跑的train,在本机一张卡上test不了 结果很简单,直接将 `model.module` 拿出来就行了 因为之前双卡用的parallel def _

还没有评论,来说两句吧...